Tanto en el ámbito europeo como en el nacional se están desarrollando estándares que contribuyan a un uso seguro, ético y responsable de la inteligencia artificial (IA). Aquí explicamos qué trabajos están actualmente en marcha.

José Antonio Jiménez Caballero

Coordinador de Digitalización

UNE

En los últimos años se ha producido una explosión de actividad relacionada con la inteligencia artificial (IA). Por un lado, cantidades ingentes de aplicaciones de la IA en todos los ámbitos, con el consiguiente impacto socioeconómico. Por otro lado, se han visto los peligros de la IA, que surgen cuando no se hace un uso seguro, ético y responsable de la misma.

Como se ha hecho con muchas otras tecnologías anteriormente, en la Unión Europea se ha elaborado una legislación común que regula la IA, y los países miembros por su parte tienen sus propias estrategias nacionales específicas en la materia, que en su conjunto permitirán disfrutar de las ventajas de la IA a la vez que se mitigan sus riesgos.

El Reglamento Europeo de Inteligencia Artificial

El Reglamento (UE) 2024/1689 del Parlamento Europeo y del Consejo, de 13 de junio de 2024, por el que se establecen normas armonizadas en materia de inteligencia artificial tiene como objetivo mejorar el funcionamiento del mercado interior mediante el establecimiento de un marco jurídico uniforme, en particular para el desarrollo, la introducción en el mercado, la puesta en servicio y la utilización de sistemas de inteligencia artificial, de conformidad con los valores de la Unión. El objetivo es promover la adopción de una inteligencia artificial centrada en el ser humano y fiable, garantizando al mismo tiempo un elevado nivel de protección de la salud, seguridad y derechos fundamentales consagrados en la Carta de los Derechos Fundamentales de la UE.

Dada la enorme variedad de campos de aplicación de la IA, conseguir los objetivos del Reglamento europeo de IA requiere imponer requisitos distintos según la aplicación de la que se trate. Para establecer un conjunto proporcionado y eficaz de normas para los sistemas de IA, el Reglamento aplica un enfoque basado en los riesgos claramente definido, que adapta el tipo y contenido de las reglas que exige a la intensidad y el alcance de los riesgos que puedan generar los sistemas de IA considerados. La clasificación por riesgo se muestra en la Figura 1.

Video. Estándares para la inteligencia artificial

Figura 1 – Clasificación de riesgos de los sistemas de IA según el Reglamento (UE) 2024/1689

Fuente: European AI Office

El papel de la normalización

Como muchas otras regulaciones europeas, bajo el modelo del Nuevo marco legislativo o “nuevo enfoque” (New Legislative Framework, NLF), el Reglamento (UE) 2024/1689 se apoyará en estándares europeos para demostrar la conformidad de los sistemas de IA con respecto a ciertos requisitos técnicos. El uso de estándares ya establecido o por venir aplicará a las siguientes categorías:

- sistemas de IA de alto riesgo;

- modelos de IA de uso general;

- presentación de información y documentación a fin de mejorar el funcionamiento de los de los sistemas de IA desde el punto de vista de los recursos, como la reducción del consumo de energía y de otros recursos.

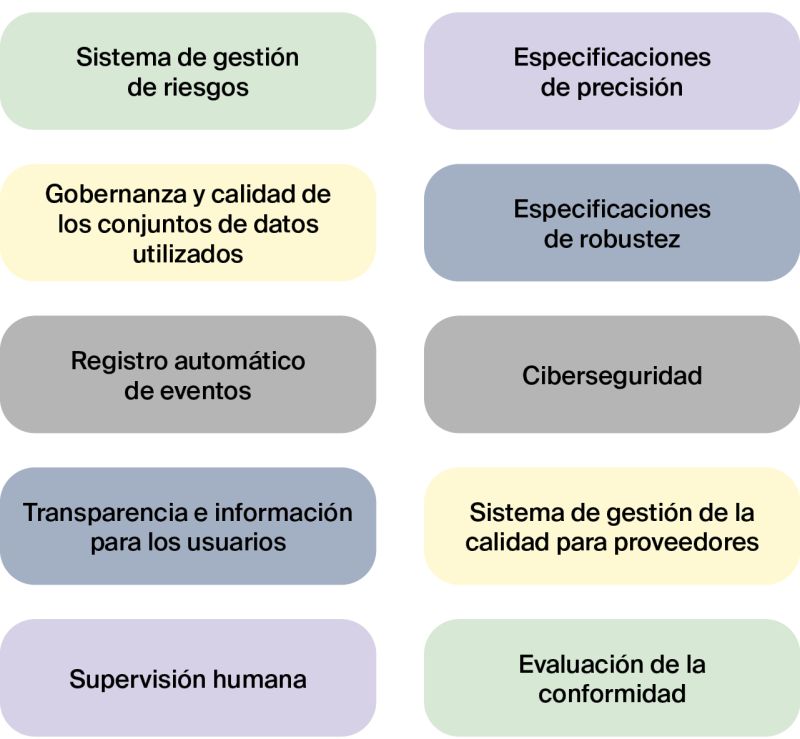

De momento, la Comisión Europea ha solicitado el desarrollo de estándares para cubrir los siguientes aspectos de los sistemas de IA de alto riesgo:

1. Sistema de gestión de riesgos

Debe concebirse como un proceso continuo e iterativo que se desarrolla a lo largo de todo el ciclo de vida del sistema de IA y que tiene por objeto prevenir o minimizar los riesgos pertinentes para la salud, la seguridad o los derechos fundamentales. Debe ser compatible con los sistemas de gestión de riesgos propios de la aplicación específica del sistema de IA cuando forme parte de un componente de seguridad de un producto determinado.

2. Gobernanza y calidad de los conjuntos de datos utilizados

Los proveedores de sistemas de IA deben aplicar los procedimientos adecuados de gobernanza y gestión de datos, y cubrir los aspectos de calidad de los conjuntos de datos utilizados para entrenar, validar y probar los sistemas de IA.

3. Registro automático de eventos

Este registro automático de eventos permitirá la trazabilidad de dichos sistemas a lo largo de su ciclo de vida, así como el seguimiento de sus operaciones, y facilitará el seguimiento posterior a la comercialización por parte de los proveedores.

4. Transparencia e información para los usuarios

Los sistemas de IA deben diseñarse de forma que garanticen la transparencia del funcionamiento para que los usuarios puedan comprender los resultados del sistema y utilizarlos adecuadamente. Deben ir acompañados de instrucciones de uso detalladas como capacidades y limitaciones del sistema, instrucciones de mantenimiento, información para perfiles de usuarios profesionales o no profesionales.

5. Supervisión humana

Los sistemas de IA deben contener medidas y procedimientos que garanticen la supervisión humana de su funcionamiento, que permitan que los usuarios comprendan, supervisen, interpreten, evalúen e intervengan en su comportamiento.

6. Especificaciones de precisión

Los proveedores de sistemas de IA deben declarar los parámetros y niveles de precisión pertinentes, incluyendo, cuando esté justificado, un conjunto de herramientas y parámetros adecuados para medir la precisión con respecto a niveles definidos.

7. Especificaciones de robustez

Los sistemas de IA deben contemplar medidas para garantizar su robustez, teniendo en cuenta las fuentes pertinentes de errores, fallos e incoherencias, así como las interacciones del sistema de IA con el entorno, incluidos los que siguen aprendiendo después de su comercialización o puesta en servicio, en particular en lo que respecta a los circuitos de retroalimentación.

8. Ciberseguridad

Deben proporcionarse soluciones organizativas y técnicas adecuadas para garantizar que los sistemas de IA sean resistentes a los intentos de alterar su uso, comportamiento y funcionamiento o de comprometer sus propiedades de seguridad por parte de terceros malintencionados que exploten las vulnerabilidades de estos sistemas.

9. Sistema de gestión de la calidad para proveedores

Los proveedores de sistemas de IA deben implantar un sistema de gestión de la calidad que asegure el cumplimiento continuo de los aspectos descritos en los puntos 2 al 8.

10. Evaluación de la conformidad

Deben establecerse procedimientos de verificación y validación de los sistemas de IA que garanticen que son adecuados para su uso y el sistema de gestión de la calidad se ha implantado de forma correcta. Estos procedimientos deben contemplar la posibilidad de una autoevaluación o una evaluación por un tercero independiente.

Los estándares que se van a utilizar para demostrar la conformidad con estos requisitos se están elaborando en el Comité europeo CEN/CENELEC JTC 21 Artificial Intelligence, utilizando en su mayor parte los estándares desarrollados en el Comité internacional ISO/IEC JTC 1/SC 42 Artificial Intelligence, para alinear los requisitos europeos con los internacionales. En el ámbito nacional, estos estándares se desarrollan en el Comité CTN-UNE 71/SC 42 Inteligencia artificial y big data de UNE.

Figura 2 – Lista de temáticas solicitadas por la CE para desarrollar estándares para los sistemas de alto riesgo

La Estrategia de Inteligencia Artificial 2024 de España

La Estrategia de Inteligencia Artificial 2024 del Gobierno de España pretende aprovechar la oportunidad que proporciona la IA como palanca de transformación económica de nuestro país, reforzando la Estrategia Nacional de Inteligencia Artificial (ENIA), que se publicó en 2020. La Estrategia de Inteligencia Artificial 2024 contiene iniciativas que pretenden generar impacto económico y social a través de la IA, en las que la normalización tiene especial relevancia. Reflejo de esa relevancia es la creación de un sello de calidad en materia de IA sostenible y el desarrollo de un ecosistema de colaboración público-privada, que se desarrolla a través del Programa Nacional de Algoritmos Verdes (PNAV).

Así, la creación de un sello de Calidad Green Tech instaurará un programa de reconocimiento de modelos de inteligencia artificial medioambientalmente sostenibles, que proporcione una ventaja competitiva a los modelos desarrollados en España. La aportación de información sobre consumo energético de los sistemas de IA de propósito general está prevista en el Reglamento (UE) 2024/1689.

En este contexto, la Secretaría de Estado de Digitalización e Inteligencia Artificial ha tomado la iniciativa de desarrollar, con el apoyo de la Asociación Española de Normalización, las Especificaciones UNE necesarias para evaluar el impacto medioambiental de los sistemas IA, sustentando con ello la concesión de dicho sello de calidad. Además, este trabajo puede servir como base al futuro proceso de estandarización europeo en esta materia, permitiendo a las empresas españolas que ya posean el sello nacional una transición más sencilla hacia los requisitos de información futuros derivados del Reglamento Europeo de IA.

Las Especificaciones UNE se están desarrollando en el Grupo de Trabajo CTN-UNE 71/SC 42/GT 1 Evaluación de la eficiencia energética de los sistemas de inteligencia artificial, liderado por la Secretaría de Estado de Digitalización e Inteligencia Artificial y en el que colaboran 63 expertos de 29 entidades.

Los estándares en IA contribuyen a cumplir con los ODS

Opinión

Normas para regular la inteligencia artificial

David de Francisco Marcos

Subdirector general de Fomento y Regulación de la Inteligencia Artificial

Secretaría de Estado de Digitalización e Inteligencia Artificial (SEDIA)

Ministerio para la Transformación Digital y de la Función Pública

La aprobación del Reglamento Europeo que establece normas armonizadas en materia de inteligencia artificial (IA), en junio de 2024, marcó un hito significativo en la regulación de esta tecnología. La IA, debido a su potencial de transformación económica y social y su carácter transversal, representa una oportunidad sin precedentes para el progreso, pero también conlleva riesgos inherentes. Desde Europa se ha buscado mitigar estos riesgos mediante un proceso regulatorio riguroso y estructurado.

La publicación del Reglamento constituye solo el primer paso dentro de un marco regulatorio más amplio y en pleno desarrollo. En este contexto, la recientemente creada AI Office europea desempeña un papel fundamental al centralizar los esfuerzos para desarrollar actos delegados, códigos de práctica y normas técnicas. Estos instrumentos tienen como objetivo precisar las medidas necesarias para cumplir con los requisitos establecidos en el Reglamento, con especial énfasis en los sistemas de IA clasificados como de alto riesgo. Asimismo, en el ámbito nacional, se está llevando a cabo un esfuerzo sustancial de adaptación a los marcos normativos internos, lo que incluye la definición de un sistema de gobernanza nacional para la supervisión de la IA y el establecimiento de procedimientos sancionadores asociados.

Uno de los retos más significativos en este proceso regulatorio es la normalización técnica. La gran cantidad de normas y estándares requeridos para respaldar la implementación técnica de la regulación plantea un desafío considerable. En este sentido, el papel de los organismos de estandarización, tanto nacionales como europeos, es crucial. Su contribución resulta indispensable para garantizar un uso de la inteligencia artificial que sea no solo responsable, sino también capaz de generar la máxima confianza entre los distintos actores implicados.

La Revista de la

Normalización Española

La Revista de la

Normalización Española